In amper twee jaar tijd is de chatbot ChatGPT voor veel mensen praktisch onmisbaar geworden. Of het nu gaat om een recept met de restjes in je koelkast, een liedtekst op de melodie van ‘Mamma Mia’ of een trainingsschema voor de halve marathon, de chatbot van het bedrijf OpenAI helpt je uit de brand. Elke dag beantwoordt ChatGPT meer dan 2,6 miljard ‘prompts’ – opdrachten en vragen – van meer dan 700 miljoen gebruikers wereldwijd. Daarnaast zijn er nog andere chatbots op basis van kunstmatige intelligentie (AI) van bedrijven als Meta, Google en Microsoft.

Heel handig, maar niet geheel zonder risico’s. De taalmodellen achter de chatbots zijn namelijk ontwikkeld door internetgiganten, getraind met teksten vol fouten en vooroordelen, die vaak ook nog onrechtmatig zijn verkregen. Nu is dat voor je recept met een halve bloemkool en drie tomaten waarschijnlijk niet direct een probleem, maar bedrijven en overheden maken zichzelf wel erg kwetsbaar met het gebruik van deze technologie. Daarom werken onderzoeksinstituut TNO, ICT-organisatie SURF en het Nederlands Forensisch Instituut (NFI) sinds eind 2023 aan een Nederlands alternatief: het taalmodel GPT-NL. Zo rond het verschijnen van dit nummer nemen de eerste organisaties het taalmodel in gebruik; daarna komt het breder beschikbaar.

Zwaard

“Kunstmatige intelligentie is een tweesnijdend zwaard”, aldus Jesse van Oort, die bij TNO verantwoordelijk is voor de dataverzameling voor het Nederlandse taalmodel. “We zien zeker de potentie, maar ook de gevaren. Momenteel heeft Nederland bijvoorbeeld nog weinig digitale soevereiniteit. Want we kunnen de bestaande, buitenlandse taalmodellen wel integreren in onze kritische infrastructuur van de overheid en defensie, maar wat als de Amerikaanse of Chinese bedrijven het gebruik ervan ineens stoppen of juist heel duur maken? Of nog erger: als ze het gebruiken om propaganda te verspreiden? Het is belangrijk dat we hierin autonoom zijn en niet afhankelijk van internationale bedrijven die ook weer eigen belangen hebben.”

Niet alleen autonomie, ook transparantie, betrouwbaarheid en het tegengaan van stereotyperingen zijn belangrijke waarden in de ontwikkeling van GPT-NL, vertelt Eliza Hobo, een collega van Van Oort. De bedrijven achter de bestaande taalmodellen doen schimmig over de software en de teksten die gebruikt worden. “Dat maakt een inhoudelijke controle onmogelijk. Daarnaast zijn de taalmodellen vooral getraind met Engelstalige data, waardoor de Nederlandse taal en cultuur niet goed gepresenteerd worden. Een Nederlandse e-mail begint bijvoorbeeld meestal niet met ‘Ik hoop dat het goed met je gaat’, zoals zulke taalmodellen vaak voorstellen.”

Schendingen van auteursrecht

Tijd voor een Nederlandstalig alternatief dus. En dat begint allemaal bij de data: gigantische verzamelingen teksten, waarmee zo’n model getraind wordt. Grote taalmodellen (ook wel large language models of LLM’s genoemd) zoals ChatGPT en GPT-NL ‘leren’ de taal door statistische verbanden te herkennen tussen woorden die in een bepaalde context vaak samen voorkomen. Waar hartelijke staat, volgt bijvoorbeeld wel erg vaak groeten. Vervolgens kan het model zelf teksten genereren door met die contextinformatie steeds het volgende woord te voorspellen. Het taalmodel begrijpt dus zelf niks van taal, het begrijpt alleen de patronen waarin woorden voorkomen. Hoe goed de teksten zijn die uit de computer rollen, ligt aan de kwaliteit en kwantiteit van de trainingsdata.

“Het verzamelen van die trainingsdata was een hele klus”, vertelt Van Oort. Dat komt doordat dit team het hier anders wilde aanpakken dan bij de meeste van de buitenlandse modellen. “Veel grote taalmodellen zijn getraind met teksten die van internet zijn ‘geschraapt’. Maar daar zitten dus ook bronnen bij als X en Reddit en dan heb je geen vat meer op de inhoudelijke kwaliteit – dus dat wilden wij niet.”

De data moesten bovendien rechtmatig worden verkregen – OpenAI, het bedrijf achter ChatGPT, is al meermaals aangeklaagd vanwege schendingen van het auteursrecht. De ontwikkelaars van GPT-NL maakten daarom afspraken met meer dan 25 partijen die bereid waren data te doneren. De data die ze verkregen, zijn grofweg onder te verdelen in drie categorieën, vertelt Van Oort. “We hebben publieke data, zoals notulen en besluiten van gemeenten en de Tweede Kamer. Zij zijn verplicht om die openbaar te maken. Daarnaast hebben we data die normaal gesproken niet vrij beschikbaar zijn. Bijvoorbeeld van kranten, van blogs als Waarbenjenu.nl en van instituten zoals de Fryske Akademy, het Instituut voor de Nederlandse Taal en het Nationaal Archief. En ten slotte nog tekst in andere vormen, zoals code in programmeertaal, waardoor het model straks beter kan redeneren.”

Het doel was om ongeveer de helft van de verzamelde data Engelstalig te laten zijn. “Uiteindelijk willen we dat het model ook gebruikt kan worden in het Engels, want dat is ook een belangrijke taal in de Lage Landen”, verklaart Van Oort. In de praktijk lukte het niet die 50% aan Nederlandstalige teksten te halen. Uiteindelijk bestaat 10% van de verzamelde data uit Nederlandse teksten – 73% is Engels en 17% bevat andere talen, zoals Zweeds en Duits. Doordat het taalmodel verbanden legt tussen woorden, houdt het verschillende talen vanzelf uit elkaar.

On, hoor en baar

Bij de selectie van de data hielden de ontwikkelaars de diversiteit in het oog. “Je wilt dat alle bevolkingsgroepen op een gelijkwaardige manier worden gerepresenteerd in de data”, vertelt Hobo. “Daarbij gaat het niet alleen om taalgebruik, maar ook om bronnen, auteurs en onderwerpen.” Om zogeheten bias, systematische discriminatie, tegen te gaan, wordt GPT-NL ook getraind met regionale, Vlaamse en Friese data. Maar de bias zit vaak in kleine dingen, en komt pas bovendrijven als het hele pakket data bij elkaar is. Bijvoorbeeld als blijkt dat islam vaker voorkomt wordt in de context van terrorisme dan van religie en cultuur.

Van Oort: “Bias is eigenlijk niet te voorkomen. Het is vooral belangrijk dat we de tekortkomingen kennen, zodat we daar transparant over kunnen zijn en kunnen adviseren waar het model wel en niet voor gebruikt kan worden. Het is ook belangrijk dat mensen het kunnen melden, zodat we het model daar in de toekomst op kunnen aanpassen. We weten bijvoorbeeld nu al dat we in een volgende versie ook bronnen uit Suriname en het Caribisch deel van het Koninkrijk erbij willen betrekken.”

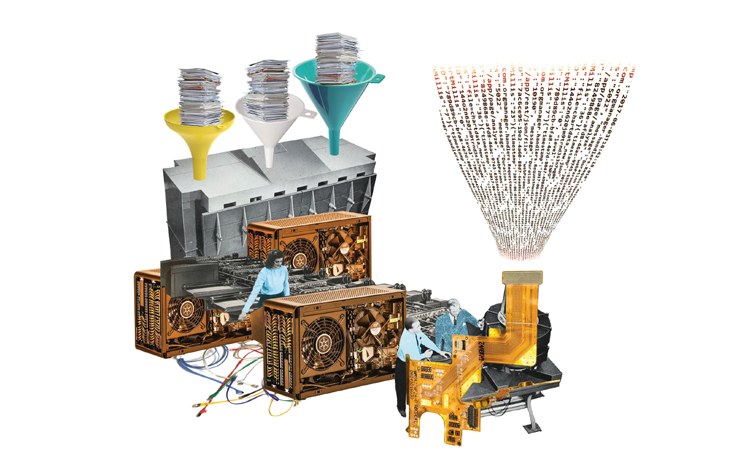

Voor deze eerste versie verzamelden de ontwikkelaars maar liefst 880 miljard ‘tokens’ aan tekstdata. Tokens zijn de bouwstenen van taal die het taalmodel herkent en produceert. Dit kunnen hele woorden zijn, maar ook delen van woorden, of leestekens. Een woord als onhoorbaar bestaat bijvoorbeeld uit drie tokens: on, hoor en baar, die elk ook weer in andere woorden voorkomen. Dit maakt het model efficiënter en flexibeler dan als het alle mogelijke woorden die beginnen met on- of eindigen op -baar als aparte tokens zou zien. Het kan dan omgaan met woorden als onblauw of zwembaar water, ook als die niet voorkomen in de teksten waarmee het is gevoed.

Kraantje Pappie

Al die verzamelde data konden niet gelijk de computer in om het systeem te voeden: eerst moesten ze worden ‘opgeschoond’. De meeste teksten die te oud waren en de huidige taal en wereld niet meer goed weerspiegelden, werden handmatig verwijderd. Ook zijn alle persoonsgegevens eruit gehaald, zoals namen, adressen, kentekens, bsn-nummers en rijksregisternummers. Alleen algemeen bekende namen mochten blijven, zodat het taalmodel straks wel weet wie Kraantje Pappie is en waar de Kalverstraat ligt.

Ook schadelijk taalgebruik werd verwijderd. Hiervoor gebruikte het team modellen die erop zijn getraind om racistische, seksistische en homofobe uitingen en doodsbedreigingen te herkennen. Helemaal waterdicht is deze methode niet; subtiel schadelijke taal zoals het seksistische en kleinerende mevrouwtje pikt hij niet op. “Dit gaat echt over vloeken en schelden, zodat het model in de basis veilig is”, legt Van Oort uit.

Uiteindelijk hielden de ontwikkelaars 370 miljard tokens over van de 880 miljard. “Nog steeds een niet te bevatten hoeveelheid”, aldus Van Oort. “Als je al die tokens zou uitprinten op A4’tjes met een normale lettergrootte, krijg je een stapel papier hoger dan de Mount Everest.”

Al die data zijn afgelopen najaar drie maanden lang dag en nacht ‘gevoerd’ aan de nationale supercomputer Snellius, waarop het taalmodel werd getraind. In deze fase trokken de onderzoekers voor de scheve taalverhouding in de trainingsdata recht. “Snellius heeft ongeveer evenveel Nederlandstalige als Engelstalige data gezien”, vertelt Van Oort. “Dat was mogelijk omdat je tijdens de training sommige data, die relevanter zijn of van hogere kwaliteit, vaker kunt laten terugkomen dan andere. Zo hebben wij voor GPT-NL de Nederlandse teksten een hogere prioriteit gegeven dan de Engelse, waardoor die er uiteindelijk vaker in zaten.”

Doorontwikkeling

Na deze training is het taalmodel nog gefinetuned. “We hebben het model 15.000 taken met antwoorden gegeven, bijvoorbeeld een tekst met een zelfgeschreven samenvatting.” Zo kan het model straks beter omgaan met allerhande instructies. Deze stap bood de ontwikkelaars gelijk een mooie gelegenheid om meer diversiteit aan te brengen: ze gebruikten hiervoor veelal teksten over Nederlandse subculturen en minderheden, zodat deze informatie ook aan het model werd meegegeven.

Vanaf begin dit jaar is de eerste versie van GPT-NL dus klaar. Die is vooral bedoeld om informatie op te zoeken en teksten te simplificeren of samen te vatten. “Er komt een gratis licentie voor onderzoekers en een betaalde licentie voor partijen die het taalmodel kunnen integreren in hun systemen, zoals bij de overheid en defensie. Zij kunnen bijvoorbeeld brieven vol jargon vereenvoudigen of rapporten laten samenvatten. Of het taalmodel koppelen aan een eigen database en het vragen laten beantwoorden over de eigen interne documenten.”

De opbrengst van GPT-NL gaat voor de helft naar de partijen die de trainingsdata geleverd hebben. Van Oort: “De andere helft blijft bij ons. We zijn een non-profitorganisatie, dus dat gaat allemaal naar de doorontwikkeling van GPT-NL. Hopelijk krijgen we daar de kans voor. Als deze versie straks gebruikt wordt, weten we nog beter wat het taalmodel kan en wat er beter moet.”

-----

Duurzaam

De klimaatimpact van grote taalmodellen als ChatGPT is groot. Zowel voor de training als voor het verwerken van de grote hoeveelheden prompts is veel energie nodig. Eén opdracht aan ChatGPT verbruikt ongeveer tien keer zoveel energie als een Google-zoekopdracht. Is GPT-NL dan niet simpelweg nog een extra vervuiler erbij? “Dat zou het wel zijn als het straks niet wordt gebruikt”, aldus Jesse van Oort van TNO. “Maar het doel is dat GPT-NL taken overneemt die nu nog met OpenAI worden uitgevoerd. Ons model is zo energie-efficiënt mogelijk. Het is getraind met minder, maar kwalitatief betere data en kan draaien op een lichter systeem, en zal dus zuiniger zijn dan Open AI.”

Alsjeblieft!

Dit artikel uit het januari/februarinummer (2026) van Onze Taal kreeg je cadeau.